Geoffrey Hinton anticipa que la Inteligencia Artificial está en vías de «tomar decisiones autónomas»

Los riesgos de las IA: su creador observa que ya «parecen personas» y que «pronto serán más listas»

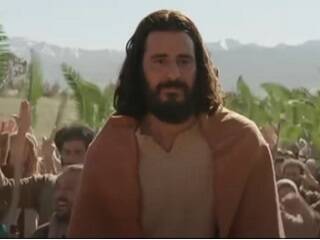

El pasado lunes, el británico Geoffrey Hinton sorprendió al mundo al renunciar a su trabajo en Google después de más de 10 años. El revuelo mediático que le llevó a ocupar las portadas de la BBC, New York Times o The Guardian está justificado. No solo por ser uno de los padres de la Inteligencia Artificial -hoy en alza con el ChatGPT de Microsoft o el Sparrow de Google- sino especialmente por su convencimiento de que, de no poner freno a estos sistemas, las consecuencias podrían ser devastadoras.

A mediados de febrero, publicábamos en Religión en Libertad una conversación mantenida con ChatGPT sobre aspectos relativos a la fe y la vivencia de la cultura cristiana y el resultado no fue alentador. La Inteligencia Artificial no anunció una amenaza que afectaría "necesariamente" a la fe, pero si plasmó que sus "parámetros morales", si es que pudiese tenerlos, son totalmente contrarios a ella: el aborto, la ideología de género, los "múltiples modelos de familia", la eutanasia, lo contenido en la leyenda negra o sus principales "fake news" son aspectos que se dan por hecho en su algoritmo.

A estas conclusiones se añaden ahora las plasmadas por su creador. A sus 75 años, el pionero en la investigación de redes neuronales y "aprendizaje profundo" de las maquinas ha cosechado otros hitos tan relevantes como "dar vida" a Siri, la asistente de IPhone, sentar las bases del coche autónomo o ganar Premio Turing, considerado el Nobel de la informática.

La "superinteligencia", un riesgo real que podría ser "aterrador"

Por eso la suya es una opinión a tener en cuenta, especialmente desde que disfruta de la libertad para hablar "sobre los peligros de la Inteligencia Artificial" sin preocuparse por los efectos que pueda tener en Google. Y algunos de esos riesgos, declaró estos días a la BBC, "son bastante aterradores".

Menciona algunos que podrían afectar al día a día o a la política internacional, como "producir automáticamente textos con información falsa" o "crear herramientas que permitan a líderes autoritarios manipular a los electores".

Pero lo que más teme el "progenitor" de la IA es "el riesgo existencial" de que su creación "se vuelva más inteligente" no solo que sus programadores, sino que la propia humanidad.

"Somos sistemas biológicos y estos son sistemas digitales. La gran diferencia es que, con los sistemas digitales, tienes muchas copias del mismo conjunto, del mismo modelo del mundo, y todas estas copias pueden aprender por separado pero comparten su conocimiento al instante. Es como si tuviéramos 10.000 personas y cada vez que una aprende algo, todas las demás lo aprenden automáticamente. Así es como estos sistemas logran saber mucho más que el resto", explica Hinton.

La primera pregunta que surge entonces es si la Inteligencia Artificial podría "eclipsar" a la inteligencia humana.

"No lo sabemos. En este momento lo que estamos viendo es que Chat GPT-4 -la última versión- supera a una persona en la cantidad de conocimiento general. En términos de razonamiento no es tan bueno, pero dado el ritmo de progreso, creemos que las cosas avanzarán bastante rápido. Tenemos que preocuparnos por eso. En este momento no son más inteligentes que nosotros, pero creo que pronto lo serán", afirma.

Desde hace años, Hinton afirma que "las máquinas serán más inteligentes que los hombres en casi todo".

"Parecen personas"... e incluso la superan

En otra reciente entrevista concedida a Technology Review, el "padrino" de la IA comparó los millones de conexiones neuronales del cerebro humano con el equivalente a algunos sistemas de inteligencia artificial como la última versión del ChatGPT. El informático enfatiza que esta versión "sabe cientos de veces más que cualquier persona" y contempla la posibilidad de que su algoritmo de aprendizaje sea "mucho mejor" que el de las propias capacidades humanas.

También menciona la similitud de algunas características de estos sistemas con la mente que los hacen "parecer personas".

Destaca por ejemplo "la capacidad de confabular" o el "aprendizaje de pocos intentos", por el que puede encadenar enunciados lógicos para formar argumentaciones aunque no hayan sido programados para hacerlo.

Otro rasgo netamente humano que podrían adquirir estos programas es el de la comunicación, pero a pasos agigantados.

"Si usted o yo aprendemos algo y queremos transferir ese conocimiento a otra persona, no podemos enviarle una copia. Pero [con la IA] puedo tener 10.000 redes neuronales, cada una con sus propias experiencias y, al instante, cualquiera puede compartir lo que ha aprendido. Es una diferencia enorme, como si fuéramos 10.000 personas, y en cuanto una aprendiera algo, el resto también lo supiésemos", explica.

Más beneficios que peligros, "a corto plazo"

Hinton no pretende ser catastrofista. Él mismo considera que la Inteligencia Artificial será "extremadamente beneficiosa" en lo relativo a la investigación científica y sanitaria, y comparte su convencimiento de que "a corto plazo" se obtendrán "muchos más beneficios que riesgos".

"No creo que debamos dejar de desarrollar estos sistemas, ver sus usos puede ser beneficioso y eso alentará a seguir desarrollándolas", agrega.

El peligro, entonces, no sería tanto la Inteligencia Artificial en sí misma, sino la ausencia de límites a la misma. Por ello Hinton se dedica a concienciar a quienes están involucrados en la IA para que se aseguren que "si desarrollan cosas más inteligentes [que las personas], no tomen el control".

"Si dejamos de desarrollarlas ahora, ese riesgo existencial se disiparía. [Pero] no creo que todo se quede como está. Vamos a desarrollarla mucho más porque es muy útil, y luego tendremos que preocuparnos por lo que pasará", advierte.

ChatGPT4 es la forma más avanzada de Inteligencia Artificial, usada por más de 100 millones de usuarios únicos al mes: sus respuestas, aún sin razonamientos complejos, son cada vez más similares a las que podría ofrecer una persona.

Más inteligentes, autónomas y multiplicándose: "¿Es una buena idea?"

En su caso, contempla que pensar que la "superinteligencia" sea buena o mala "depende de si uno es optimista o pesimista".

"Si se pide a la gente que calcule el riesgo de que sucedan lo peor, como la posibilidad de que un familiar enferme de gravedad o sea atropellado por un coche; un optimista diría que es del 5% y un pesimista dirá que eso sucederá. Pero una persona algo desalentada dirá que las probabilidades rondan el 40%, y tendría razón", explica.

En este sentido, el científico se muestra "desalentado" y no duda en afirmar que siente "miedo": "He cambiado de opinión sobre si estas herramientas van a ser más inteligentes que nosotros. Creo que ahora están muy cerca de serlo. ¿Cómo sobreviviremos a eso?".

Cuando Hinton es preguntado por los riesgos de la Inteligencia Artificial a largo plazo, explica que "el peor de los casos" podría ser su uso con fines bélicos, dando a los robots "la capacidad de crear sus propios objetivos" y "subobjetivos".

Algo que ya se encuentra en marcha a través de proyectos experimentales, como BabyAGI y AutoGPT, que conectan chatbots con otros programas para encadenar tareas sencillas. Hinton se pregunta lo que sucedería cuando, de lograrse, la IA aplicase esta capacidad para aspectos bélicos o inmorales.

Lo explica con un ejemplo: "Tengo un objetivo, por ejemplo, llegar al aeropuerto. Entonces debo configurar el subobjetivo de conseguir un taxi, por lo que mi subobjetivo es llamar a un taxi. La capacidad de crear subobjetivos hace que los agentes sean mucho más efectivos. Así se le dará a los robots la capacidad de crear subobjetivos. Pero una vez que haces eso, entonces pueden crear subobjetivos como `necesito obtener más poder´, porque si obtienen más poder, podrán lograr mejor sus objetivos. Otro objetivo sería hacer más copias de sí mismo. ¿Eso parece una buena idea?".